本文内容

-

LangChain(大模型能力封装框架) 的基本使用

-

基于LangChain探索AGI时代原型

需提前安装环境依赖,以及设置环境变量,如果选择openai开放接口需要会上网

export OPENAI_API_KEY="b233095ff.00gIXhXyE8yNc3Hx"

export OPENAI_BASE_URL="https://open.bigmodel.cn/api/paas/v4"LangChain核心组件

-

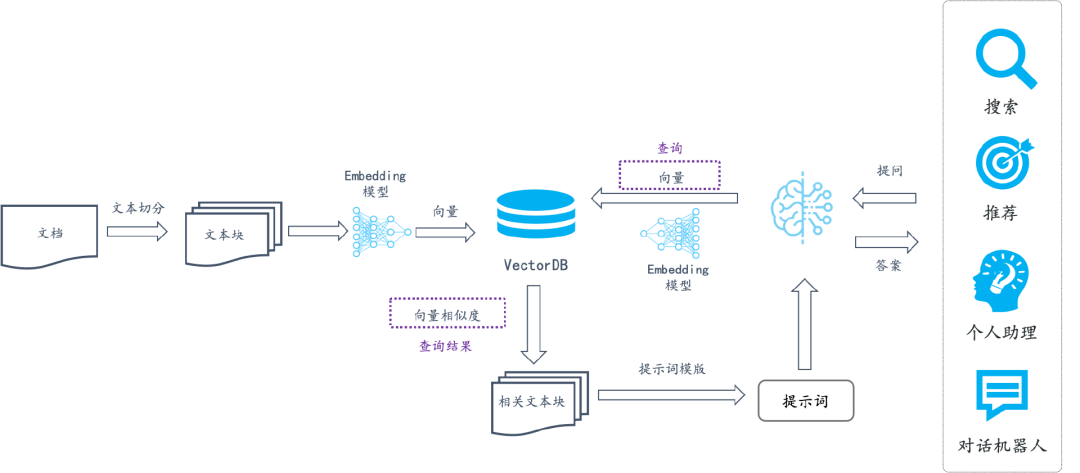

模型I/O封装(LLMs、Chat Models、PromptTemple、OutputParser)

-

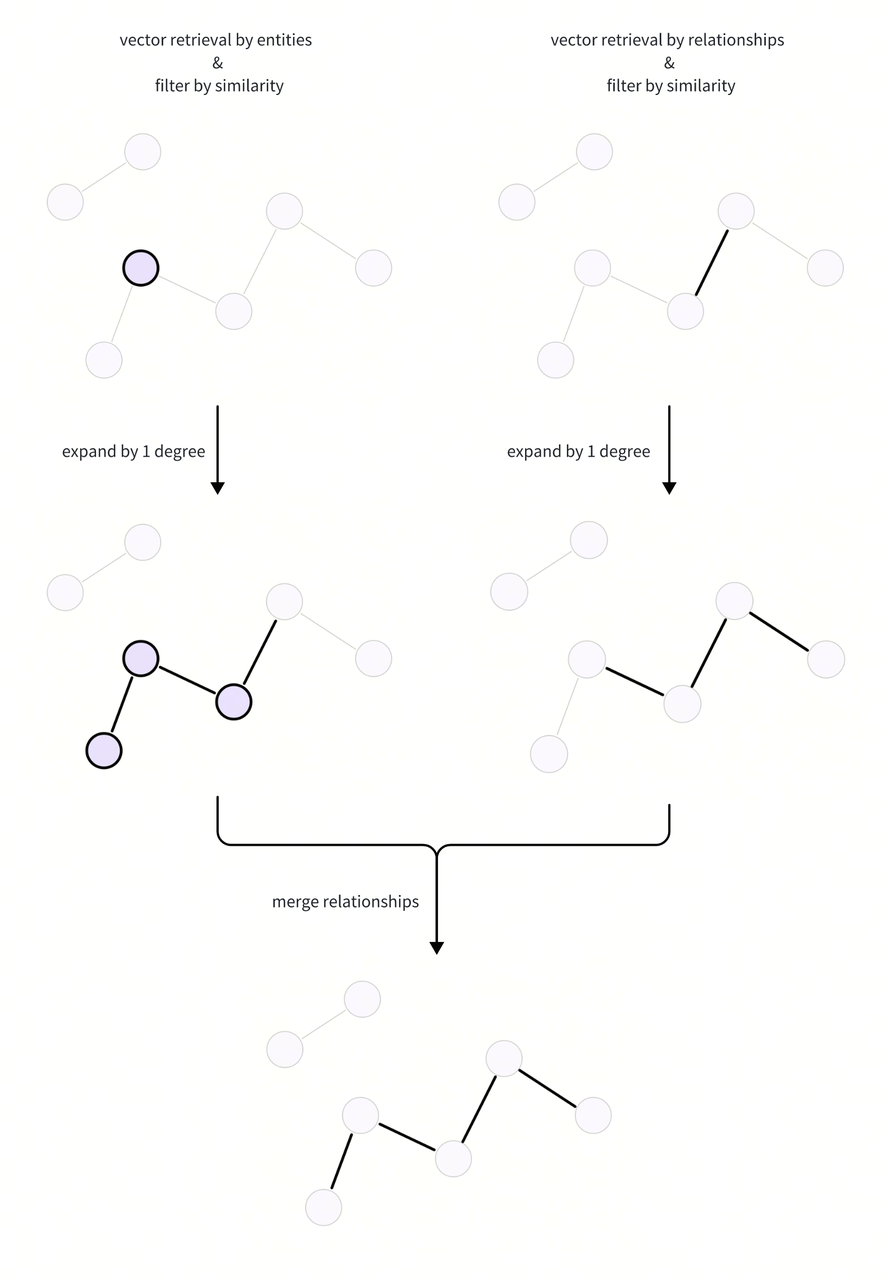

数据链接封装(Document Loaders、Document Transformers、Text Embedding Models、VerctorStores、Retrievers)

-

对话历史管理

-

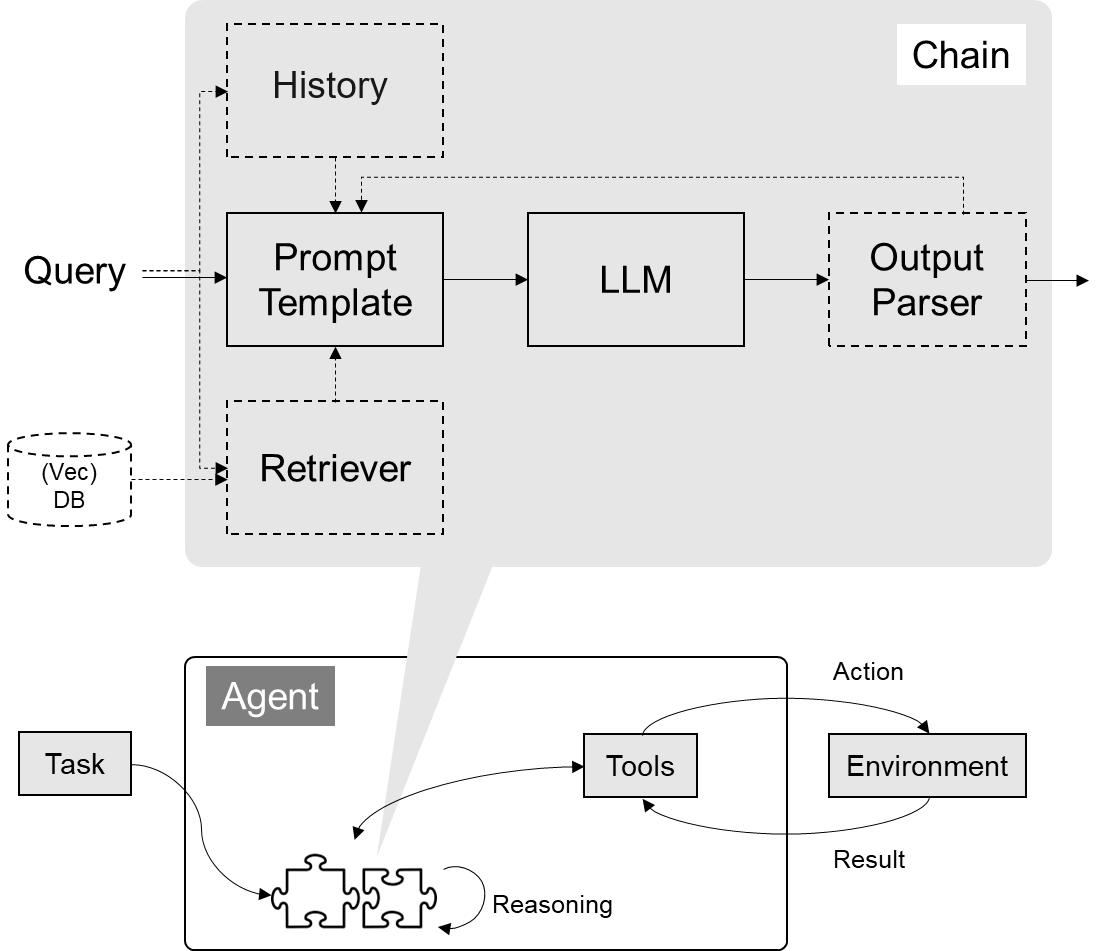

架构封装(Chain、Agent、Tools、Toolkits)

-

Callbacks